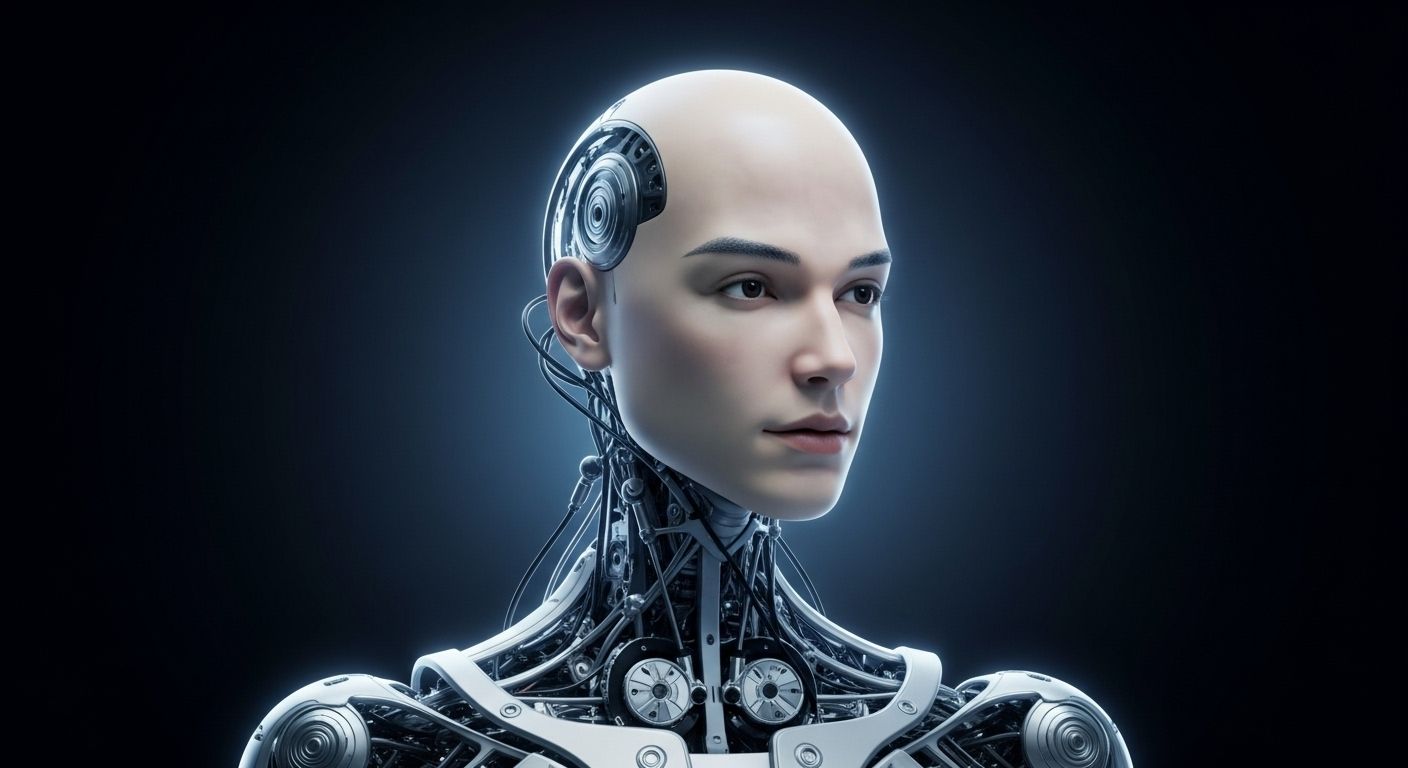

En un laboratorio oculto entre los rascacielos de Shenzhen, donde el aire huele a cables quemados y café frío, una cabeza robótica parpadea lentamente, gira hacia un ingeniero y esboza una sonrisa que parece casi humana. No es un simple movimiento mecánico, sino una expresión calculada para transmitir empatía, como si el robot supiera que está siendo observado. Esta es Origin M1, la última creación de AheadForm, una startup china que no se conforma con construir robots que caminen o hablen, sino que busca replicar la esencia misma de la comunicación humana: los gestos, las miradas, los pequeños detalles que hacen que una interacción se sienta real. «No queremos máquinas que funcionen, queremos máquinas que conecten», explica Li Wei, cofundador de la compañía, mientras ajusta los 25 actuadores brushless que dan vida a los músculos faciales del prototipo. Lo que parece un simple avance técnico es, en realidad, un salto revolucionario: por primera vez, un robot no solo puede hablar, sino interpretar el lenguaje no verbal y responder con expresiones que, hasta ahora, eran exclusivas de los humanos.

El desafío de humanizar a las máquinas no es nuevo, pero hasta ahora los avances se habían centrado en la movilidad (robots que caminan, corren o incluso hacen parkour) o en la inteligencia artificial (asistentes que responden preguntas con precisión). Sin embargo, como señala un estudio publicado en Science Robotics en 2024, el 60% de la comunicación humana es no verbal: un gesto de aprobación, una mirada de complicidad o un frunce de cejas pueden transmitir más que mil palabras. «Un robot puede decir ‘te entiendo’, pero si no asiente o no mira a los ojos, no lo creemos», explica Yuhang Hu, investigador principal del proyecto. Origin M1 no solo parpadea o mueve los labios al hablar, sino que analiza el tono de voz, la postura y las expresiones faciales de su interlocutor para ajustar sus respuestas. «No es solo una cabeza que se mueve, es un sistema que intenta entender el contexto emocional», añade Hu, mientras el robot gira lentamente hacia él, como si estuviera escuchando con atención.

Lo que hace único a este prototipo es su capacidad de adaptación en tiempo real. Mientras otros robots se limitan a seguir guiones preprogramados, Origin M1 utiliza cámaras ocultas en sus pupilas y micrófonos direccionales para captar señales sutiles: un suspiro de frustración, una sonrisa nerviosa o un movimiento de manos que delata impaciencia. «Si detecta que estás confundido, puede fruncir el ceño y preguntar: ‘¿Necesitas que repita algo?'», explica Li Wei, mientras el robot demuestra exactamente eso: sus cejas se arquean levemente, sus labios se curvan en una expresión de preocupación y su voz —suave pero clara— formula la pregunta. «Es la diferencia entre interactuar con una máquina y sentir que alguien te está escuchando». Esta capacidad no es solo un avance técnico, sino un cambio filosófico en cómo concebimos la robótica: ya no se trata de reemplazar a los humanos, sino de crear puentes entre lo artificial y lo emocional.